Artificiell intelligens (AI) är en av de mest banbrytande teknologierna i vår tid. AI innebär att datorer och system kan analysera data, lära sig av erfarenheter och fatta beslut med minimal mänsklig inblandning. På bara några decennier har AI utvecklats från att vara en teoretisk idé till en teknik som påverkar många aspekter av vårt dagliga liv, från smarta telefoner och självkörande bilar till avancerad sjukvård och finans.

Denna snabba utveckling medför stora möjligheter, såsom effektivare processer, förbättrad diagnos inom medicin och innovationer som tidigare var otänkbara. Men samtidigt medför AI också betydande risker som vi inte kan ignorera. Dessa risker påverkar både individer, samhällen och den globala säkerheten.

Syftet med denna artikel är att belysa potentiella risker med AI, från integritetsproblem och arbetslöshet till säkerhetsfrågor och etiska dilemman. Genom att förstå dessa risker kan vi arbeta för att hantera dem på ett ansvarsfullt sätt och samtidigt dra nytta av AI:s möjligheter.

Risker för individen med AI

Integritetsproblem

En av de största riskerna med AI är dess beroende av stora mängder data för att fungera effektivt. AI-system tränas ofta på data som samlats in från användare, vilket innebär att personlig information kan användas på sätt som individer inte alltid är medvetna om eller godkänt.

Exempelvis används AI i övervakningsteknik, där kameror med ansiktsigenkänning kan identifiera och spåra människor i realtid. Detta kan öka säkerheten i vissa fall, men det kan också leda till intrång i individers privatliv. Ett annat exempel är AI-drivna annonser som analyserar din webbhistorik, köpvanor och sociala medieaktiviteter för att skapa skräddarsydd reklam. För många känns det påträngande att bli ”övervakad” på detta sätt.

Denna omfattande datainsamling skapar risker för dataintrång och missbruk av information, vilket kan leda till förlust av privatliv och känslig information som hamnar i fel händer.

Bias och diskriminering

AI är bara så bra som de data den tränas på. Om dessa data innehåller fördomar eller obalanser, kan AI förstärka och reproducera dessa på en mycket större skala. Detta kallas ofta för bias i AI.

Ett exempel är AI-system som används vid rekrytering. Om systemet tränas på historisk data som speglar en fördomsfull arbetskultur, kan det prioritera kandidater av ett visst kön, en viss etnicitet eller bakgrund. Liknande problem har uppstått i rättsväsendet, där AI-användning för att förutsäga brottslighet har visat sig vara partisk mot vissa minoritetsgrupper.

Diskriminering kan också inträffa i ekonomiska beslut, som kreditvärdering. Ett AI-system som analyserar data för att godkänna lån kan oavsiktligt exkludera vissa grupper på grund av omedvetna fördomar i datan.

Dessa konsekvenser understryker behovet av att granska och förbättra de data och algoritmer som används i AI-system.

Förlust av jobb och arbetsroller

En av de mest debatterade risker med AI är dess påverkan på arbetsmarknaden. Automatiseringen som drivs av AI ersätter allt fler arbetsuppgifter som tidigare utfördes av människor. Robotar och AI-system används redan för att hantera kundtjänst, köra fordon och till och med skriva enklare nyhetsartiklar.

Inom vissa sektorer, som tillverkning och transport, har AI redan lett till att många jobb försvunnit. På längre sikt kan yrken som kräver mindre kreativitet och mänsklig interaktion vara särskilt utsatta.

Samtidigt skapar AI också nya arbetsmöjligheter inom områden som teknikutveckling och datavetenskap. Men övergången till dessa nya roller kan vara svår, särskilt för arbetare utan rätt utbildning. Detta kan leda till ökande arbetslöshet och ekonomiska klyftor mellan olika grupper i samhället.

Risker för samhällen med AI

Övervakningsstater och auktoritära regimer

AI har blivit ett kraftfullt verktyg för övervakning, vilket innebär stora risker för medborgerliga friheter i samhällen där tekniken används för att kontrollera och förtrycka befolkningar.

Ett tydligt exempel är användningen av ansiktsigenkänning, där kameror kan identifiera och spåra individer i realtid. Detta används redan i vissa länder för att övervaka medborgares rörelser och aktiviteter. I händerna på auktoritära regimer kan sådan teknologi bli ett verktyg för att tysta politiska dissidenter, undertrycka protester och övervaka sociala interaktioner.

Ett annat oroande exempel är sociala kreditsystem, där AI används för att analysera medborgares beteende och ge poäng baserat på deras handlingar. I dessa system kan medborgare som inte ”följer reglerna” möta konsekvenser som att nekas banklån, jobb eller till och med resor. Dessa metoder riskerar att skapa ett klimat av rädsla och begränsa individers frihet att uttrycka sig och leva sina liv utan ständig övervakning.

Även om övervakning kan användas för att förbättra säkerheten i vissa situationer, måste balansen mellan säkerhet och frihet hanteras noggrant för att förhindra missbruk av AI i övervakningssyfte.

Polarisering och desinformation

En annan betydande samhällsrisk med AI är dess roll i spridningen av desinformation och polarisering. AI-teknologi, särskilt inom maskininlärning, används för att skapa och sprida falsk information i form av ”deepfakes” – manipulerade bilder och videor som ser äkta ut men som är skapade för att vilseleda.

Deepfakes kan användas för att undergräva trovärdigheten hos offentliga personer, sprida lögner och förvärra politiska konflikter. Till exempel har videor skapats där politiska ledare ser ut att säga eller göra saker som de aldrig gjort. Detta kan skapa kaos, påverka val och minska allmänhetens förtroende för nyhetskällor.

AI-algoritmer som driver sociala medieplattformar kan dessutom förstärka polarisering genom att prioritera innehåll som skapar starka känslor och engagemang. Genom att analysera användarnas beteende visar algoritmer ofta inlägg som bekräftar deras redan existerande åsikter, vilket kan leda till filterbubblor och extremism.

Risker för den globala säkerheten med AI

Vapenteknologi och AI

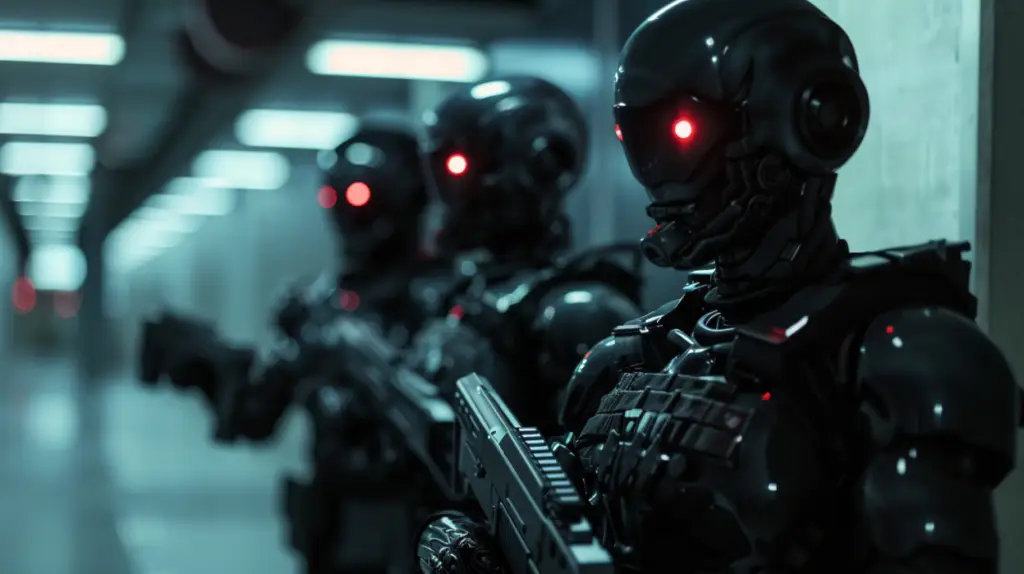

Utvecklingen av AI inom vapenteknologi innebär både möjligheter och allvarliga risker. Autonoma vapen, även kallade ”killer robots”, kan fatta beslut om att attackera mål utan direkt mänsklig kontroll. Även om detta kan leda till mer precisa militära operationer, skapar det också stora etiska och säkerhetsmässiga utmaningar.

En av de största riskerna med autonoma vapen är möjligheten till oavsiktliga konflikter. Om en AI-baserad drönare eller robot misstolkar en situation kan den avfyra vapen utan att korrekt bedöma konsekvenserna. Detta kan leda till eskalerande konflikter mellan nationer, särskilt i redan instabila regioner.

En annan risk är att dessa teknologier kan hamna i händerna på icke-statliga aktörer eller terroristorganisationer. Sådana grupper kan använda AI-drivna vapen för att utföra attacker som är svåra att förhindra eller spåra.

För att hantera dessa risker behövs internationella regleringar och avtal. Diskussioner om att begränsa eller förbjuda autonoma vapen har påbörjats i FN, men framstegen är långsamma. Det är avgörande att nationer samarbetar för att förhindra en AI-driven kapprustning som kan hota global säkerhet.

Cyberattacker och AI

AI spelar också en allt större roll i cyberattacker, vilket ökar hoten mot den globala säkerheten. Med hjälp av AI kan angripare skapa mer sofistikerade och svårupptäckta attacker. Ett exempel är ”phishing”-attacker som anpassas automatiskt baserat på målpersonens digitala beteende och kommunikationsstil, vilket gör dem betydligt svårare att identifiera som falska.

AI kan också användas för att manipulera system på större skala, som att infiltrera företagsnätverk eller kritiska infrastrukturer. Till exempel kan AI-algoritmer utnyttjas för att hitta och exploatera sårbarheter i system, vilket gör cyberattacker snabbare och mer effektiva än tidigare metoder.

En oroande utveckling är hur AI kan användas för att stjäla känslig data eller störa samhällsviktiga tjänster som elnät, vattenförsörjning och kommunikation. Sådana attacker kan få katastrofala konsekvenser för både nationell och internationell säkerhet.

För att möta dessa hot krävs robusta cybersäkerhetssystem och internationellt samarbete för att övervaka och förhindra AI-drivna cyberattacker. Företag och regeringar måste investera i att utveckla AI-system som kan identifiera och blockera potentiella attacker innan de orsakar skada.

Exempel på misslyckanden med AI

Historiska fall av AI-misslyckanden

AI-system har visat sig vara kraftfulla verktyg, men de är långt ifrån felfria. Det finns flera exempel där AI har orsakat betydande skador, felaktiga beslut eller ekonomiska förluster.

Ett känt fall är Amazon AI-rekryteringsverktyg, som skapades för att automatisera anställningsprocessen. Verktyget visade sig vara partiskt och diskriminerade kvinnor genom att undervärdera deras ansökningar. Detta berodde på att systemet hade tränats på historisk data som speglade en mansdominerad arbetsplats.

Ett annat exempel är Tesla Autopilot, där olyckor inträffat på grund av att systemet inte korrekt identifierat hinder eller trafiksignaler. I vissa fall har dessa misstag lett till dödsfall, vilket har väckt frågor om säkerheten hos autonoma system.

AI har också orsakat ekonomiska förluster, som i fallet med Knight Capital, ett finansiellt företag som förlorade 440 miljoner dollar på grund av en felaktig algoritm som handlade aktier utan mänsklig övervakning.

Lärdomar från dessa fall

Dessa misslyckanden visar att AI-system inte är immuna mot problem som bias, felaktiga beslut och tekniska brister. De understryker behovet av noggrann testning, transparenta algoritmer och mänsklig övervakning för att minimera riskerna.

För att AI ska kunna användas på ett säkert och ansvarsfullt sätt behöver vi också tydliga regler och riktlinjer för dess utveckling och tillämpning. Detta inkluderar att granska hur data samlas in och används samt att säkerställa att algoritmerna inte reproducerar skadliga mönster.

Etiska och filosofiska frågor

AI och mänskligt ansvar

En av de mest omdebatterade frågorna kring AI är vem som ska hållas ansvarig för beslut som fattas av AI-system. Om en självkörande bil orsakar en olycka, är det tillverkaren, programmeraren, ägaren eller bilen själv som bär ansvaret?

Dessa frågor blir särskilt komplexa när AI används i kritiska sammanhang, som sjukvård eller rättsväsende. Till exempel, om en AI-algoritm rekommenderar en behandling som leder till oönskade konsekvenser, vem är då skyldig?

För att hantera detta behövs transparenta algoritmer och ”förklarbar AI” (explainable AI), vilket innebär att systemens beslut och processer kan förstås och granskas av människor. Förklarbarhet är avgörande för att bygga förtroende och säkerställa att AI används på ett rättvist sätt.

AI:s påverkan på mänsklig autonomi

AI kan också påverka människors självständighet och beslutsförmåga. Många AI-baserade system är utformade för att ge rekommendationer eller fatta beslut åt användare, vilket kan minska behovet av mänsklig inblandning.

Ett exempel är AI-drivna rekommendationer på streamingtjänster som Netflix eller Spotify, där algoritmer väljer innehåll åt dig baserat på dina tidigare preferenser. Även om detta kan vara bekvämt, kan det också leda till att människor förlorar kontrollen över sina val och fastnar i ”filterbubblor”.

AI används också i beslutsstödsystem för ekonomi, hälsa och utbildning, där det ibland kan ersätta mänsklig expertis. Risken är att människor blir överberoende av AI och inte längre ifrågasätter de beslut som systemen fattar, vilket kan få negativa konsekvenser om algoritmerna är felaktiga eller partiska.

För att bevara mänsklig autonomi är det viktigt att balansera fördelarna med AI med behovet av att säkerställa att människor fortfarande har sista ordet i viktiga beslut.

Hur vi kan hantera riskerna med AI

Regelverk och lagstiftning

För att minimera riskerna med AI är starka regelverk och lagstiftning nödvändiga, både på nationell och internationell nivå. Eftersom AI påverkar allt från individers privatliv till global säkerhet behöver vi tydliga riktlinjer för hur teknologin får utvecklas och användas.

Ett aktuellt exempel är EU:s AI-förordning, ett omfattande regelverk som syftar till att skapa en rättvis och säker användning av AI i Europa. Förordningen klassificerar AI-system baserat på deras risknivå, från lågriskapplikationer till högriskområden som sjukvård och rättsväsende. Högrisk-AI kräver striktare kontroller, transparens och ansvarsutkrävande.

Internationellt behövs också samarbete för att hantera gränsöverskridande utmaningar, som AI-driven desinformation och autonoma vapen. Organisationer som FN har börjat diskutera globala riktlinjer, men det krävs mer engagemang och samordning för att undvika en AI-kapprustning och säkerställa att teknologin används på ett etiskt sätt.

Ansvarsfull AI-utveckling

Företag som utvecklar AI har en avgörande roll i att skapa säkra och etiska system. Ansvarsfull AI-utveckling innebär att integrera etiska riktlinjer i hela processen, från design till implementering. Detta kan inkludera:

- Utvärdering av bias: Att regelbundet granska data och algoritmer för att minimera diskriminering och partiskhet.

- Säkerhet i centrum: Att prioritera säkerhet och integritet för användarna genom att bygga robusta system som skyddar mot intrång och missbruk.

- Förklarbarhet: Att utveckla AI-system som kan förklara sina beslut på ett sätt som är förståeligt för människor.

Företag som Google och Microsoft har skapat interna etiska råd för AI-utveckling, medan andra organisationer, som OpenAI, arbetar för att sprida kunskap om ansvarsfull användning av AI.

Ansvarsfull AI-utveckling handlar också om att främja samarbete mellan företag, akademi och myndigheter för att säkerställa att teknologin gynnar samhället i stort.

Öppenhet och medvetenhet

Öppenhet om hur AI-system fungerar är avgörande för att bygga förtroende hos användarna. Det innebär att företag och utvecklare ska vara tydliga med hur data används, vilka beslut AI-system fattar och varför. Transparens minskar risken för missbruk och ökar möjligheterna att identifiera och åtgärda problem tidigt.

Utbildning och medvetenhet är också centrala för att hantera AI:s risker. Genom att utbilda både allmänheten och beslutsfattare om AI:s möjligheter och faror kan vi skapa en bättre förståelse för teknologin. Detta inkluderar att lära användare att känna igen och motverka AI-genererad desinformation, som ”deepfakes”, och att förstå vikten av datasäkerhet.

Organisationer som arbetar med AI kan bidra till ökad medvetenhet genom att erbjuda utbildningsresurser, workshops och lättillgänglig information om hur deras system fungerar.

Avslutning

AI är en av vår tids mest kraftfulla och omvälvande teknologier, men den medför också betydande risker. Från integritetsproblem och bias till hot mot den globala säkerheten är det tydligt att vi måste hantera dessa utmaningar proaktivt.

Genom att införa starka regelverk, främja ansvarsfull AI-utveckling och öka medvetenheten hos allmänheten kan vi minska riskerna och säkerställa att AI används på ett sätt som gynnar hela samhället.

Framtiden för AI är inte bara fylld av utmaningar utan också av möjligheter. Om vi lyckas balansera teknologins potential med dess risker kan AI bli ett kraftfullt verktyg för att lösa några av världens mest komplexa problem, från klimatförändringar till sjukdomar.

Som läsare kan du bidra genom att sprida medvetenhet om AI:s risker och möjligheter. Engagera dig i diskussionerna om hur teknologin ska regleras och användas, och uppmuntra andra att göra detsamma.